DeepSeek-R1 模型凭借其出色的性能表现,吸引了众多技术爱好者的目光。看下面的本地部署该模型,深入探索其强大功能,那

一、基础环境搭建

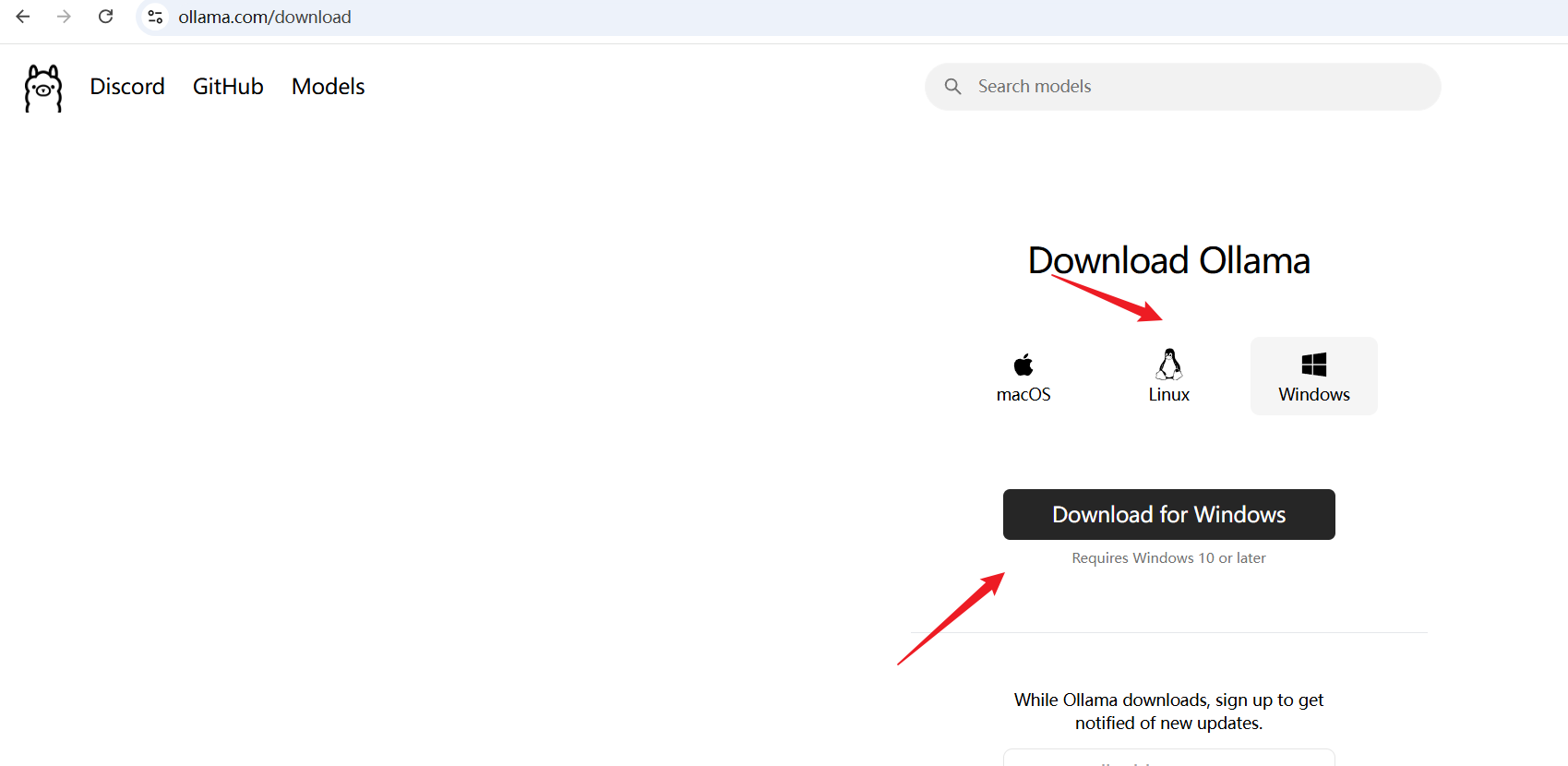

(一)安装 Ollama

-

常规下载

-

首先,访问 Oll ama 官 网 ,根据你的操作系统(Windows、Mac 或 Linux),选择对应的安装包进行下载。下载完成后,按照安装向导的提示逐步完成安装。在安装过程中,Ollama 服务会自动在电脑后台运行。对于 Linux 系统用户,还可以在终端执行curl -fsSL https://ollama.com/install.sh | sh来完成安装。

-

解决网络慢问题

-

如果在下载过程中遇到网络速度过慢的情况,可以尝试以下方法:

-

https://github.moeyy.xyz/

安装验证

-

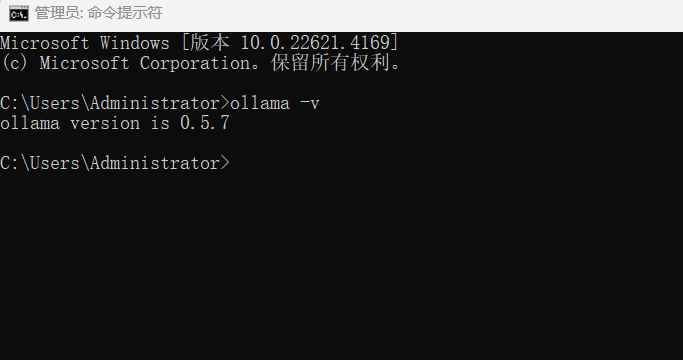

安装完成后,为了确认 Ollama 是否成功安装,在终端输入ollama -v 。如果安装正确,终端会显示 Ollama 的版本号,这就表明你已经成功完成了基础环境搭建的第一步。

-

ollama -v

二、模型部署

(一)依据硬件精准选型

-

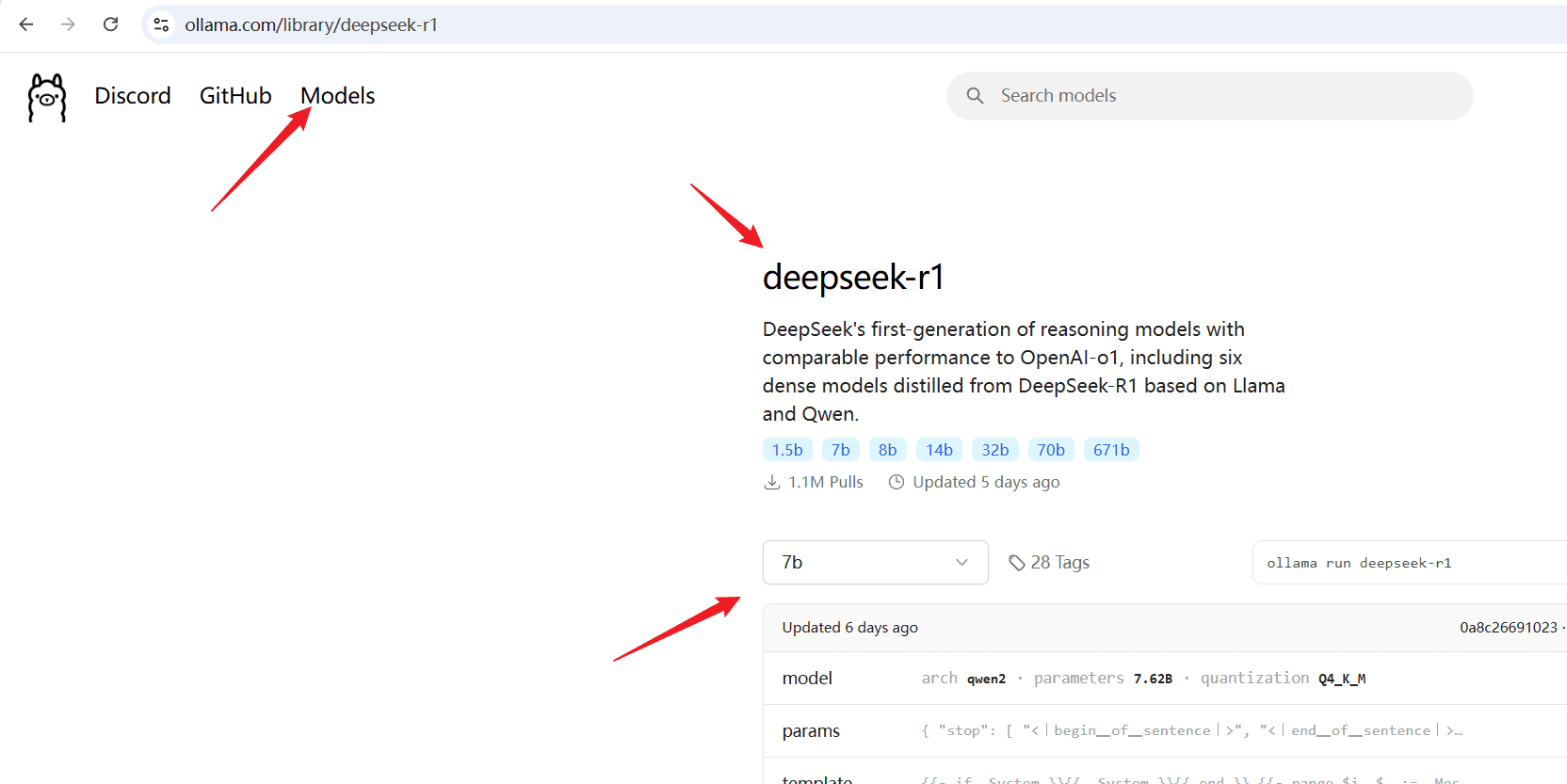

打开 Ollam a 模型库 ,你会看到丰富多样的 DeepSeek-R1 模型版本,如 1.5B、7B、32B 等。根据自身电脑硬件配置来选择合适的模型版本至关重要。

-

-

低配置硬件适配 :如果你的电脑硬件配置较为基础,CPU 是老旧的双核或四核处理器,运行内存仅有 8GB 及以下,显卡为集成显卡或者独立显卡的显存不足 2GB ,那么 DeepSeek-R1-Distill-Llama-1.5B 模型是最佳选择。它对硬件资源的需求极低,能够在这样的设备上稳定运行,轻松应对日常对话、简单文本生成等基础文本处理任务,满足你的日常使用需求。

-

中配置硬件适配 :若你的电脑配置处于中等水平,配备像英特尔酷睿 i5 系列或者 AMD 锐龙 5 系列这样性能不错的 CPU,内存达到 16GB,显卡显存为 4 – 6GB ,那么 DeepSeek-R1-Distill-Llama-7B 或 DeepSeek-R1-Distill-Qwen-7B 模型将是你的得力助手。这类模型在中等配置的电脑上能够充分发挥潜力,运行效率较高,能够轻松处理简单代码生成、文章润色等具有一定复杂度的任务,帮助你完成更多有挑战性的工作。

-

高配置硬件适配 :对于电脑硬件配置高端的用户,拥有英特尔酷睿 i7/i9 系列或 AMD 锐龙 7/9 系列这种高性能 CPU,内存达到 32GB 及以上,显卡搭载 NVIDIA GeForce RTX 30 系列、AMD Radeon RX 6000 系列等高性能独立显卡,显存高达 8GB 及以上,此时 DeepSeek-R1-Distill-Llama-32B 甚至更高版本的模型,才是充分发挥你电脑硬件实力的不二之选。它们能够承担复杂的自然语言处理任务,如专业领域的文本深度分析、复杂代码的编写与调试等,为你带来高效且优质的使用体验。

-

(二)顺利下载与稳定运行

-

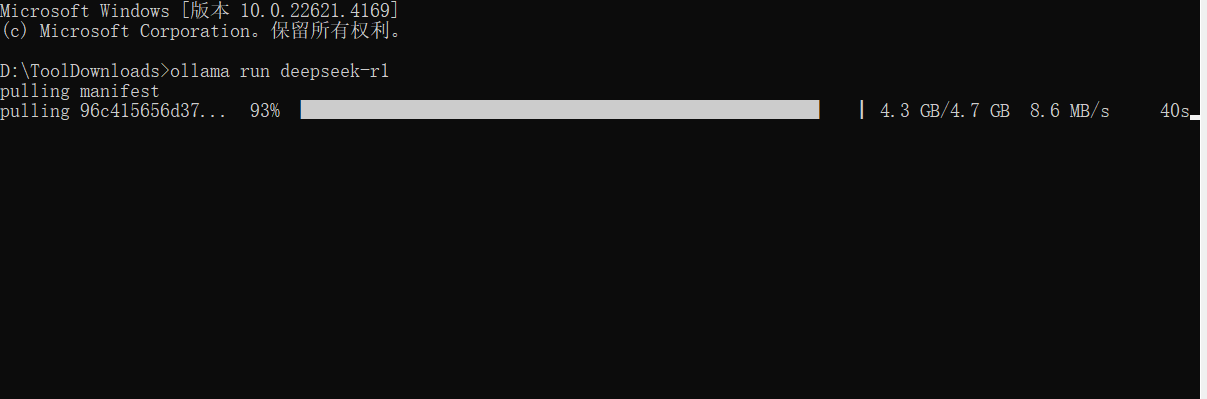

确定适合自己电脑配置的模型版本后,就可以开始下载和运行模型了。打开终端或 CMD 命令窗口,输入对应的运行指令:

-

若选择 1.5B 版本,输入ollama run deepseek-r1:1.5b 。

-

若选择 7B 版本,输入ollama run deepseek-r1:7b 。

-

若选择 32B 版本,输入ollama run deepseek-r1:32b 。

三、打造专属 AI 聊天室

(一)下载 Chatbox 客户端

为了更便捷地与部署好的 DeepSeek-R1 模型进行交互,你可以下载开源客户端 Chatbox。访问 官网 即可进行下载。Chatbox 支持中文界面与 Markdown 渲染,使用起来非常方便。

(二)关键配置

-

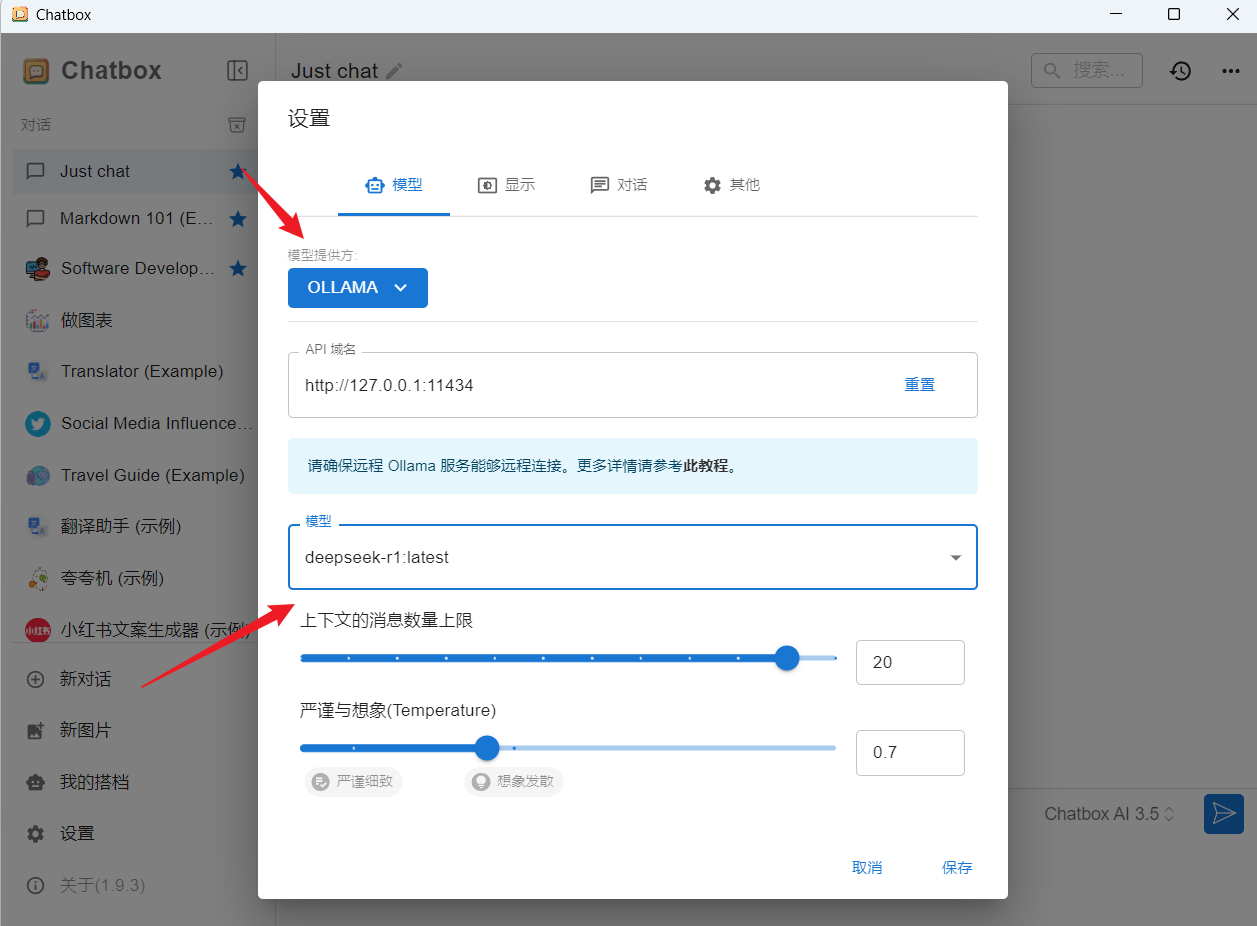

下载安装好 Chatbox 后,打开软件进行关键配置:

-

API 类型 :选择 “OLLAMA”,这一步能确保 Chatbox 与我们部署的 DeepSeek-R1 模型进行正确通信。

-

接口地址 :填写http://localhost:11434 ,这个地址是 Ollama 服务的默认接口地址,通过它 Chatbox 可以连接到本地运行的 DeepSeek-R1 模型。

-

模型名称 :务必填写与之前下载的模型版本完全一致的名称,例如,如果之前下载的是 7B 版本,模型名称就必须填写deepseek-r1:7b ,否则可能会导致连接失败。

-

下面是收集的Deepseek教程大全,可以去看一下!

deepseek使用技巧大全 链接:https://pan.quark.cn/s/b5523db53691

25年deepseek本地部署教程 链接:https://pan.quark.cn/s/7c18602042bc

- 转载请注明原文出处并保留链接,感谢配合!

- 本站资源及文章均源自互联网公开渠道整理,本站不参与任何形式的制作与编辑。如涉及版权争议,请立即联系我们处理。

- 特别提示:本站分享资源均为互联网公开信息,部分内容可能存在水印或推广信息。请用户务必仔细甄别,理性判断,自主决策。

- 重要声明:本站资源仅限用于学术研究及个人学习交流,严禁用于商业用途!任何未经授权的商业使用所引发的法律纠纷及责任,均由使用者自行承担。